Que tal, solo para comentarles que es posible tener ciertos contratiempos accesando mi blog durante los proximos dias, ya que estaré migrando mi hosting, todo para poder incluir nuevas funcionalidades y capacidades al blog.

Saludos!!!

Que tal, solo para comentarles que es posible tener ciertos contratiempos accesando mi blog durante los proximos dias, ya que estaré migrando mi hosting, todo para poder incluir nuevas funcionalidades y capacidades al blog.

Saludos!!!

Que tal gente el día de hoy vamos a revisar algunos tips o puntos para considerar cuando diseñamos una solución distribuida de Horizon View (branch offices). Estos puntos fueron comentados en una lista de distribución interna en VMware y me parece que es importante compartirla con ustedes.

Para conocer mas sobre VADC (View Agent Direct Connect), les sugiero los siguientes artículos:

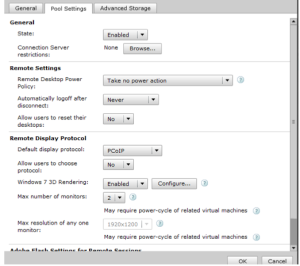

Básicamente VADC nos permite tener una conexión de PCoIP directa desde un cliente de Horizon View hacia un agente de Horizon View en un escritorio virtual, esto sin necesidad de tener un Connection Server de pormedio.Aquí lo interesante es que debemos tener en consideración cuando estemos integrando VADC en nuestros diseños distribuidos de Horizon View, vamos a echarle un ojo a los puntos importantes que debemos tener en mente:

Como pueden ver son puntos bastante sencillos pero que vale la pena tener en mente cuando comencemos un diseño distribuido de Horizon View incluyendo VADC.

Que tal gente, el día de hoy vamos a hablar sobre lo nuevo que se agrega con este release de Horizon View 5.3, en su principio la versión internamente estaba considerada como 5.2.1, pero es claro que la cantidad de capacidades e impacto de las mismas modificó esto y se entregó como una versión diferente.

¿Que tenemos de nuevo?

Que tal gente, solo una pequeña noticia/anuncio, comencé a escribir para un sitio llamado Intense School, donde pueden encontrar recursos de entrenamiento en distintos productos de manera gratuita. Intense School provee entrenamiento personalizado y en sitio para profesionales de TI, les recomiendo dar un vistazo a todos los articulos gratuitos que tienen de distintas tecnologías.

Pueden encontrar todo este material en la siguiente liga:

Aquí podrán encontrar los distintos artículos que estaré escribiendo, cabe destacar que esta en ingles. Mi primer articulo lo encuentran en esta liga:

Que tal gente, el día de hoy vamos a hablar rápidamente de un nuevo fling que nos entrega VMware Labs… vSphere Replication Capacity Planning Appliance (¿Nombre largo? :D). Recordemos que estos “flings” son herramientas o “previews” de tecnología que no tienen soporte por parte de VMware (aunque muchas veces estas tecnologías son agregadas a productos existentes).

¿Que es vSphere Replication Capacity Planning Appliance?

Este appliance virtual esta pensado para poder darnos una idea de la cantidad de información que estaremos replicando a través de vSphere Replication (replicación por medio de el hipervisor IP). Nos permite conocer el tráfico que estaría sucediendo a través de nuestros enlaces para replicar una VM en especifico, esto es muy útil ya que para poder dimensionar correctamente el ancho de banda y los RPOs para las VMs necesitamos conocer que tan “rápido” cambia la VM o esta teniendo cambios a nivel de los distintos bloques que constituyen su almacenamiento virtual, tratando de hacer esto de manera manual significa poder conocer el ritmo al cual cambia la VM, después tener esto a la mano debemos calcular lo que tomaría enviar estos cambios o “deltas” a través de nuestro enlace (sin considerar la replicación inicial de la VM donde se envía toda la VM), la formula se vería de la siguiente manera sin haber modificado ningún parámetro avanzado de buffers:

Size of changed data (bits) / Transfer speed (bps)= Transfer Time (seconds)

(esta fórmula la pueden encontrar en el articulo de Kene Wernebug, Sr. Technical Marketing Architect de BC/DR en VMware)

Pero este cálculo manual tiende a poder fallar, a tomar mucho tiempo y no ser tan preciso, es por eso que parte del equipo de desarrolladores de vSphere Replication se dieron a la tarea de crear este fling sencillo de utilizar para podernos apoyar en el dimensionamiento de nuestras replicaciones a través de vSphere.

Básicamente este appliance simula la replicación de una VM en específico que nosotros seleccionemos, en base a esto nos muestra la cantidad de ancho de banda utilizado y el “delta” (cambios en la VM) o información que sería enviada a la ubicación de DR a través de el enlace.

¿Como utilizo este appliance?

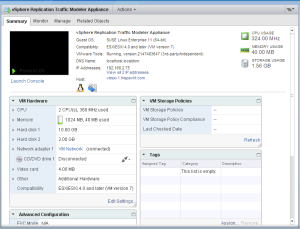

Uno de los puntos que me gusto bastante es la simplicidad para configurar este appliance, simplemente importamos el appliance a vCenter a partir de un .OVF, configuramos su IP y ¡Voila! esta listo para utilizarse:

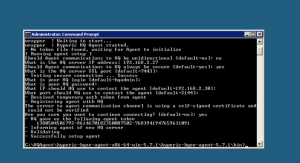

Una vez que tenemos arriba el appliance virtual a través de SSH debemos ejecutar un comando para poder definir que VM estará siendo analizada:

Una vez que tenemos arriba el appliance virtual a través de SSH debemos ejecutar un comando para poder definir que VM estará siendo analizada:

./bin/configureReplication –vc IPDEVM –vcuser USUARIODEVCENTER –vcpass PASSWORD –lwd IPDEAPPLIANCE –vmname NOMBREDEVMASERANALIZADA

Con este comando estaremos dictando que vCenter es el que aloja la VM que necesitamos analizar, el appliance de vSphere Replication Capacity Planning y las credenciales necesarias para poder acceder a vCenter, una vez ejecutado el comando podemos ver que se comienza con la simulación:

A partir de 10 a 15 minutos podemos abrir un navegador y apuntar a la IP de nuestro appliance para poder observar la información que esta recolectando, esta información es mostrada en intervalos de horas, días, semanas y meses considerando 2 valores, LWD traffic que sería el ancho de banda utilizado y Delta Size que se trata de la información enviada (que ha cambiado de la VM) con esto (tomando en cuenta que monitoreamos todo el ciclo de producción de la VM) podemos dimensionar vSphere Replication y definir los RPOs que seremos capaces de cumplir:

A partir de 10 a 15 minutos podemos abrir un navegador y apuntar a la IP de nuestro appliance para poder observar la información que esta recolectando, esta información es mostrada en intervalos de horas, días, semanas y meses considerando 2 valores, LWD traffic que sería el ancho de banda utilizado y Delta Size que se trata de la información enviada (que ha cambiado de la VM) con esto (tomando en cuenta que monitoreamos todo el ciclo de producción de la VM) podemos dimensionar vSphere Replication y definir los RPOs que seremos capaces de cumplir:

¿Donde encuentro este Fling?

Recordemos que este y muchos mas flings son publicados en el sitio web de VMware labs:

Los invito a darle un vistazo a todos los flings que están disponibles, existen bastantes que son muy útiles.

Que tal gente, el día de hoy vamos a hablar sobre una tecnología que a mis ojos parece tener bastante potencial, claramente estaremos hablando de una versión 1.0 del producto por lo que debemos comprender que muchas cosas iran siendo agregadas conforme el tiempo pase. Esta vez voy a hablarles de vSphere App High Availability, tecnología de VMware que fue liberada a con vSphere 5.5, como lo podemos notar en su nombre es alta disponibilidad para nuestras aplicaciones vamos a darle un vistazo:

¿Que es vSphere App HA?

Todos conocemos (¿O eso creo?) vSphere HA, que nos permite brindar alta disponibilidad a nivel de VM protegiéndola contra caídas de infraestructura… a grandes rasgos realiza un reinicio de las VMs fallidas en un servidor que se haya caído o tenga problemas. ¿Pero que pasa con las aplicaciones?, digamos que tenemos un servidor ESXi funcional, la VM con el servicio esta siendo ejecutada sin ningún problema, pero dentro de esta vm en el sistema operativo guest la aplicación/servicio esta caído, en este caso HA nunca reiniciaría la VM debido a que esto no forma parte de su “responsabilidad” aquí es donde entra vSphere App HA, que en conjunto con Hyperic nos brinda la capacidad monitorear los servicios que están dentro de una VM para poder definir políticas que nos permitan ejecutar acciones correctivas para mantener la disponibilidad del servicio o aplicación que tenga dicha VM.

El poder de este producto es brindado por hyperic, para poder tener monitoreo dentro de nuestras VMs necesitamos instalar el agente de Hyperic en cada VM que tenga servicios soportados que queramos protejer con App HA. En el laboratorio de Hispavirt podemos ver como tengo el appliance virtual de Hyperic para este fin:

En este servidor de Hyperic iremos agregando todos los agentes para que se puedan monitorear los servicios que existen en dichas VMs.

En este servidor de Hyperic iremos agregando todos los agentes para que se puedan monitorear los servicios que existen en dichas VMs.

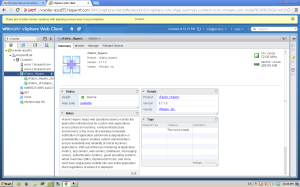

App HA interactua con vSphere y Hyperic a través de un plugin de NGC (Next Generation Client) o el vSphere Web Client, que nos permite apuntar a un servidor de hyperic para registrar el servicio (existen algunos pasos que debemos de realizar en hyperic para tener las alarmas de vCenter funcionando esto lo pueden encontrar aquí) este plugin lo brinda el appliance virtual de App HA:

Una vez lista la configuración podemos comenzar a crear políticas para proteger los servicios que son descubiertos por el agente de Hyperic en nuestras VMs, para esta versión se tiene una lista definida de servicios soportados donde podemos encontrar los siguientes:

En el laboratorio me di a la tarea de crear una VM con Windows 2008R2 y IIS7, donde instale y configuré el agente de Hyperic para que esta fuera registrada en el inventario:

Una vez instalado debemos verificar que es presentado en el “auto discovery” de hyperic y lo agregamos a nuestros recursos:

Una vez instalado debemos verificar que es presentado en el “auto discovery” de hyperic y lo agregamos a nuestros recursos:

Cuando ya tenemos lista la VM dentro de Hyperic podemos comenzar con la creación de políticas, para que estas sean asignadas a dichas VM y así proteger el servicio o aplicación que este ejecutándose dentro de ella, para motivos de la demostración seleccione las siguientes opciones para un servicio de IIS7:

Cuando ya tenemos lista la VM dentro de Hyperic podemos comenzar con la creación de políticas, para que estas sean asignadas a dichas VM y así proteger el servicio o aplicación que este ejecutándose dentro de ella, para motivos de la demostración seleccione las siguientes opciones para un servicio de IIS7:

Que son las opciones de “remediación” ofrecidas en el caso que el servicio de la VM se encuentre abajo. Podemos notar que tenemos la principal función que es “reiniciar” el servicio, donde definimos cuanto tiempo le toma iniciar a este servicio, en este caso puse 2 minutos aunque claro que esto debe de ir de la mano de lo que se tarde en su ambiente, después seleccione la opción de “Restart the VM in the event that the service is unstable” que nos permite dictarle a App HA que si no es capaz de levantar el servicio en repetidas ocasiones durante una ventana de tiempo definida (en este caso 2 veces en 10 minutos) que proceda a reiniciar la VM ya que puede ser un problema mas complicado a nivel del sistema operativo y un reinicio ayude a resolverlo.

Que son las opciones de “remediación” ofrecidas en el caso que el servicio de la VM se encuentre abajo. Podemos notar que tenemos la principal función que es “reiniciar” el servicio, donde definimos cuanto tiempo le toma iniciar a este servicio, en este caso puse 2 minutos aunque claro que esto debe de ir de la mano de lo que se tarde en su ambiente, después seleccione la opción de “Restart the VM in the event that the service is unstable” que nos permite dictarle a App HA que si no es capaz de levantar el servicio en repetidas ocasiones durante una ventana de tiempo definida (en este caso 2 veces en 10 minutos) que proceda a reiniciar la VM ya que puede ser un problema mas complicado a nivel del sistema operativo y un reinicio ayude a resolverlo.

Aquí pueden ver que mi política quedo creada y lista para ser asignada a la VM que tiene IIS7:

Después debemos asignar esta política a la VM que será protegida con AppHA, para esto vamos a nuestro vSphere Web Client y seleccionamos nuestro vCenter Server, donde veremos una pestaña llamada “Monitor” y dentro de esta pestaña tendremos una nueva sección agregada por App HA “Application Availability” donde podremos agregar nuestra política:

Después debemos asignar esta política a la VM que será protegida con AppHA, para esto vamos a nuestro vSphere Web Client y seleccionamos nuestro vCenter Server, donde veremos una pestaña llamada “Monitor” y dentro de esta pestaña tendremos una nueva sección agregada por App HA “Application Availability” donde podremos agregar nuestra política:

Una vez aplicada la política si tenemos una caída del servicio App HA nos dará un aviso en el “status” y tomará cartas en el asunto para poder levantarlo, también podemos notar que se envía una alarma de vCenter Server:

Como podemos ver la configuración, creación de políticas y el como trabaja App HA es bastante amigable, en mi caso no me tarde mas de 15 minutos en dejar lista la configuración de vCenter y Hyperic (de hecho me tarde mas tiempo en descargar los appliances de App HA y Hyperic). En esta versión tenemos la capacidad de proteger servicios con un mecanismo sencillo, claramente como lo dice su nombre se trata de “alta disponibilidad” a diferencia de una tolerancia a fallos que nos podría dar un servicio de cluster a nivel de la aplicación, pero para muchos casos de uso esta alta disponibilidad funciona cubre las necesidades o los SLAs definidos.

Como podemos ver la configuración, creación de políticas y el como trabaja App HA es bastante amigable, en mi caso no me tarde mas de 15 minutos en dejar lista la configuración de vCenter y Hyperic (de hecho me tarde mas tiempo en descargar los appliances de App HA y Hyperic). En esta versión tenemos la capacidad de proteger servicios con un mecanismo sencillo, claramente como lo dice su nombre se trata de “alta disponibilidad” a diferencia de una tolerancia a fallos que nos podría dar un servicio de cluster a nivel de la aplicación, pero para muchos casos de uso esta alta disponibilidad funciona cubre las necesidades o los SLAs definidos.

¿Que necesito para poder tener App HA?

Como han visto a lo largo del articulo necesitamos de algunos componentes “extra” de lo que viene siendo vSphere (ESXi y vCenter) que son:

En el caso de Hyperic podemos optar por el appliance virtual que ya incluye el servidor y la base de datos como parte de un vApp, para poder cubrir el máximo de agentes que están soportados por App HA que son 400,necesitaríamos una configuración “medium” para el servidor de Hyperic (4vCPUs y 8GB de RAM) mientras que para la base de datos necesitaríamos una configuración “medium” (4vCPUs y 6GB RAM), como podemos ver para Hyperic estaríamos hablando de una cantidad de recursos de alrededor de 14GB en RAM y 8vCPUs, esto sin considerar que tengamos mas de 500 agentes a monitorear lo cual no podría ser cubierto por un “conjunto” de vCenter + Hyperic + App HA (la relación es 1:1:1).

En el caso del appliance de App HA los requerimientos son bastante bajos, 2 vCPUs, 4GB RAM, 20GB en disco y 1Gbps en red. Con respecto a la plataforma que estará monitoreando vSphere App HA trabaja con Hyperic 5.7+, ESXi 5.5 y vCenter 5.5.

Una duda que he encontrado (que yo mismo tuve en su momento) fue el hecho de el licenciamiento de Hyperic, si consideramos que estaremos monitoreando varias instancias de sistema operativo podríamos pensar que necesitaríamos una licencia para cada uno de estos en lo que a Hyperic se refiere, pero esto no es correcto, con el simple hecho de importar el appliance virtual de Hyperic y contar con vSphere Ent+ tenemos todo cubierto, si… sin necesidad de licenciamiento de Hyperic.

Que tal gente, el día de hoy vamos a hablar de lo nuevo que nos ofrece vCD 5.5, hemos estado revisando lo nuevo que nos ofrecerá vSphere 5.5 en el momento que sea liberado al publico (GA), pero todavía no tocamos otros productos que también fueron mejorados entre los cuales se encuentra vCD.

Mejoras a nivel de vApp

Aquí estaremos revisando las mejoras que impactan directamente a nuestras VMs o servicios:

Catálogos

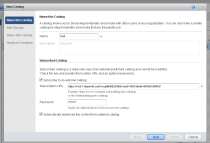

En esta sección tenemos capacidades que vienen a cubrir distintas peticiones por los usuarios de vCD, podemos ver casos de uso distribuidos, tiering etc. Vamos a conocer las nuevas capacidades:

se maneja a través de versiones de el catálogo, aquí podemos pensar en distintos casos de uso, por ejemplo, publicación de un catálogo a distintas organizaciones, ambientes distribuidos geograficamente, distintas instancias de vCD, etc. El catálogo a ser suscrito deberá presentar una password y el link para suscribirse, una vez que este esta suscrito a través de un protocolo llamado vCSP (VMWare Content Suscription Protocol) se realizarán las deciciones si se necesita actualizar cierto archivo que tenga una nueva versión o que sea nuevo en el catálogo, todo esto sucede siempre a través de un “pull”, es decir, el catálogo suscrito descargará la información del catálogo origen, nunca se tendrá un “Push” de información. Algo interesante es que los suscriptores pueden seleccionar un modelo “on–demand” que unicamente descarga el metadata de dicho catalogo y no la información en su totalidad, el listado de objetos mostrará todo el contenido y en el caso de requerir un objeto (ej. ISO) se realiza una sincronización manual con un click derecho y “syncrhonize”.

se maneja a través de versiones de el catálogo, aquí podemos pensar en distintos casos de uso, por ejemplo, publicación de un catálogo a distintas organizaciones, ambientes distribuidos geograficamente, distintas instancias de vCD, etc. El catálogo a ser suscrito deberá presentar una password y el link para suscribirse, una vez que este esta suscrito a través de un protocolo llamado vCSP (VMWare Content Suscription Protocol) se realizarán las deciciones si se necesita actualizar cierto archivo que tenga una nueva versión o que sea nuevo en el catálogo, todo esto sucede siempre a través de un “pull”, es decir, el catálogo suscrito descargará la información del catálogo origen, nunca se tendrá un “Push” de información. Algo interesante es que los suscriptores pueden seleccionar un modelo “on–demand” que unicamente descarga el metadata de dicho catalogo y no la información en su totalidad, el listado de objetos mostrará todo el contenido y en el caso de requerir un objeto (ej. ISO) se realiza una sincronización manual con un click derecho y “syncrhonize”.Acceso y configuración

Extensibilidad

vCD 5.5 tiene la capacidad de registrar dos extensiones para interactuar con ellas, vFabric Data Director y Cloud Foundry. Esto permite a los administradores presentar a las organizaciones servicios de DBaaS (Database As A Service) y SaaS (Software As A Service).

NOTA: Aquí comparto con ustedes lo que yo he aprendido a lo largo del tiempo, no es la verdad absoluta ni pretendo ser experto en el tema (al menos en el momento que escribo este articulo) por lo que si en este articulo notan errores o áreas que puedan ser mejoradas, modificadas, etc. Por favor ¡Comenten! Recuerden que estamos acá para compartir conocimiento y ser lo mas acertados posible.

Que tal gente, el día de hoy les voy a hablar sobre algo que esta en todos,TODOS lados… que al igual que el cloud computing o “computo de nube” ha sido repetido una y otra vez hasta que nos (Hemos ¿cansado?) familiarizado con el. En esta ocasión estaré hablando sobre Openstack, daremos un vistazo a que es Openstack, que necesidades o casos de uso cubre y donde exactamente estaría situado en nuestro datacenter o en el stack de software y de igual manera estaré hablando de que NO es openstack.

En VMworld asistí a varias sesiones de Openstack debido a que mi interés ha crecido bastante por lo que me dí a la tarea de dejar de ser alguien que lee sobre el tema y pasar a ser alguien que conozca openstack y pueda contribuir a la comunidad de habla hispana sobre este tema.

¿Que es Openstack?

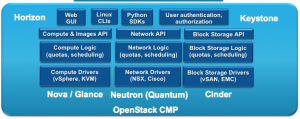

Openstack es un conjunto de proyectos “open-source” o de codigo abierto, en sus inicios quienes contribuyeron con mas código fué rackspace y la NASA. Este conjunto de proyectos y grupo de empresas/desarrolladores tienen como objetivo el construir una plataforma de nube, como tal Openstack podría considerarse como un CMP o “Cloud Management Platform” que permite orquestrar y gestionar distintos aspectos de una infraestructura para dar servicios de nube. Si quisieramos hacer una analogía contra el stack de VMware, Openstack estaría al mismo nivel de vCAC (aunque podría compararse en ciertos puntos con vCD).

Lo interesante de OpenStack es su capacidad de extensibilidad a través de APIs que son “faciles” de consumir (muy al estilo de AWS), públicos y son “vendor free”, por lo que muchos service providers han volteado a ver a OpenStack como un posible elemento clave para su infraestructura. Esta pensado de manera modular de tal manera que en base a los requerimientos de “nube” que se necesiten entregar podemos ir integrando distintos proyectos a nuestra arquitectura.

Existen varios proyectos que conforman a Openstack, vamos a revisar los mas relevantes (para quienes venimos de un mundo VMware):

Imagen compartida por Scott Lowe @scott_lowe

Imagen compartida por Scott Lowe @scott_lowe

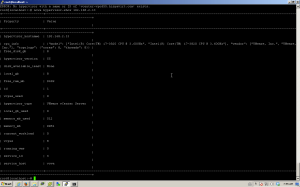

(Cluster de vCenter registrado en Nova)

(Cluster de vCenter registrado en Nova)

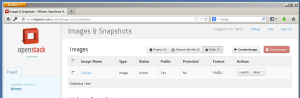

(imagenes disponibles vistas desde horizon)

(imagenes disponibles vistas desde horizon)

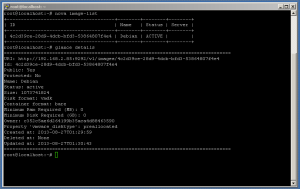

(Detalles de la imagen a través de glance)

(Detalles de la imagen a través de glance)

Como podemos ver distintos proyectos conforman el “framework” de OpenStack, en este articulo no tocamos todos los proyectos que están allá afuera, pero estaré escribiendo artículos de mayor profundidad en los proyectos y tratar de hablar sobre los que aquí no fueron descritos.

¿Que NO es Openstack?

OpenStack no es:

Algunos casos de Uso

OpenStack ofrece la capacidad de IaaS muy al estilo de AWS, donde las cargas,instancias o VMs, como nosotros nos guste llamarlas no son del todo tratadas a un nivel tan especifico como lo podemos hacer a nivel de vSphere+vCD, vSphere+vCD+vCAC, esto debido a que no existen mecanismos para el control de los SLAs (alta disponibilidad, control de “noisy neighbors (NetIOC,SIOC, etc)”, donde tal vez el brindar alta disponibilidad lo realizamos a través de la aplicacion/gOS, donde básicamente tenemos que diseñar para el fallo. Ambientes enterprise donde manejemos aplicaciones tier1 que tienen que cumplir al 100% con sus SLAs, tener manera de asegurar el rendimiento y demás (básicamente consentirlas mas :D) en este punto se verían mas beneficiadas de ambientes basados en vSphere.

Les recomiendo TOTALMENTE leer dos artículos de Massimo Re Ferre @mreferre sobre este tema donde podrán entender el principio de como se tratan a las cargas en distintos tipos de nube y cuales son indicadas para que tipo de aplicación y/o servicio:

http://it20.info/2012/12/vcloud-openstack-pets-and-cattle/

http://it20.info/2011/04/tcp-clouds-udp-clouds-design-for-fail-and-aws/

Entonces, regresando al tema de VMware vs OpenStack, mas bien les diría que piensen en OpenStack sobre “(aquí va el hipervisor/CMP)”…

Que tal gente, continuando con la serie de artículos sobre lo nuevo que nos trajo vSphere es momento de hablar sobre vCenter y vSphere replication.

vCenter 5.5

Con esta nueva versión de vSphere llegaron mas que nuevas capacidades, mejoras a nivel de vCenter tanto en su forma de appliance virtual como en la versión de Windows.

De igual manera se agregan capacidades para como los “quick filters” que nos permite crear filtros de manera muy rápida y sencilla en la busqueda. Se agrega soporte para drag & drop de objetos a nivel del inventario, permitiéndonos así tener una navegación y uso del cliente mucho mas amigable de lo que se tenia en versiones anteriores, por último algo que para mi (y ciertamente todos los usuarios de OSX) es increbile fue que oficialmente se agrega soporte para Mac OS con capacidades como la consola de HTML para visualizar e interactuar con las VMs, transferencia de OVFs y uso de ISOs locales.

De igual manera se agregan capacidades para como los “quick filters” que nos permite crear filtros de manera muy rápida y sencilla en la busqueda. Se agrega soporte para drag & drop de objetos a nivel del inventario, permitiéndonos así tener una navegación y uso del cliente mucho mas amigable de lo que se tenia en versiones anteriores, por último algo que para mi (y ciertamente todos los usuarios de OSX) es increbile fue que oficialmente se agrega soporte para Mac OS con capacidades como la consola de HTML para visualizar e interactuar con las VMs, transferencia de OVFs y uso de ISOs locales.Como pueden ver no todas son “nuevas” capacidades sino como lo dije al inicio del articulo son mejoras a lo ya existente.

vSphere Replication

En el área de vSphere Replication (sin considerar SRM) se tienen de igual manera mejoras y nuevas funcionalidades vamos a revisar que nos trajo vSphere 5.5 pero para esto vamos a recordar que es vSphere Replication a grandes rasgos.

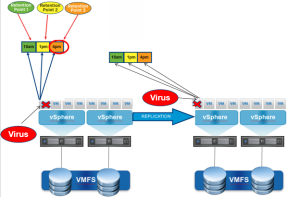

vSphere Replication nos permite realizar replicación de tipo asíncrona de nuestras VMs, en este caso hablamos de replicación a nivel del vmkernel (hipervisor) por lo que no se requiere ni agentes, ni una arquitectura y/o tecnología uniforme ya que al trabajar a nivel del hipervisor todo este tipo de temas quedan abstraídos. Definimos un RPO o Recovery Point Objective (tiempo al cual queremos poder recuperar en el caso que se tenga un problema) y esto nos permite fijar los periodos de replicación, en versiones interiores este punto al cual podiamos regresar era unico, es decir, cada replicación sustituía a la anterior.

En esta versión se agrega algo bastante interesante, la capacidad de poder retener varios puntos hacia donde podemos recuperar una VM (o un VMDK en especifico) a esta funcionalidad se le llama MPIT “Multiple Points In Time”

Esto nos permite el poder regresar a puntos específicos del tiempo donde tengamos distintos estados de la VM, algunos casos de uso pueden ser bastante amplios debido a la flexibilidad. Las distintas replicas o puntos a los que nos podemos recuperar se presentan como “Snapshots” por lo que nosotros seleccionamos el punto al que nos queremos recuperar como lo haríamos desde el snapshot manager (maximo 24 replicas).

Esto nos permite el poder regresar a puntos específicos del tiempo donde tengamos distintos estados de la VM, algunos casos de uso pueden ser bastante amplios debido a la flexibilidad. Las distintas replicas o puntos a los que nos podemos recuperar se presentan como “Snapshots” por lo que nosotros seleccionamos el punto al que nos queremos recuperar como lo haríamos desde el snapshot manager (maximo 24 replicas).

Esta capacidad de MPIT o múltiples puntos de tiempo no esta disponible desde SRM solo a través de vSphere Replication.

Otras mejoras:

La gestión de vSphere Replication forma parte de la interfaz de vCenter, por lo que lo gestionamos desde una “pestaña” o sección de nuestro cliente.

Estén atentos para un articulo donde estaré cubriendo a profundidad vSphere Replication 5.5 y SRM 5.5.

Que tal gente, continuando con los artículos sobre lo nuevo que nos trajo VMworld (muchas cosas además de vSphere) es turno de meternos de lleno a lo que nos ofrece VMware con vFlash. Esta nueva funcionalidad nos permite acelerar operaciones de lectura a nivel de VMDK de máquina virtual, por lo cual dependiendo del caso de uso y tipo de aplicación puede ser de bastante interesante.

Debemos comenzar por definir algunos términos que estaremos manejando en el articulo:

“Solid State Drive”, este tipo de disco a diferencia del tradicional o mecánico no tiene partes móviles lo que permite tener tiempos de acceso mucho mas rápidos y menor latencia. Si lo comparamos con una memoria USB estos dos comparten algo en común, el hecho que ambos almacenan información en memoria flash, claramente los discos de estado solido tienen una estructura semejante a un disco tradicional y son mucho mas sofisticados que una simple memoria USB. La cantidad de IOPS en un SSD se encuentra en el orden de los miles y a diferencia de un disco mecánico estos son mucho mejores en operaciones de lectura que en escritura, esto debido a que no se puede sobre escribir información sin que se ejecute un proceso llamado “garbage collection” lo que permite la escritura en esa ubicación cosa que no sucede en un disco mecánico de cualquier manera generalmente tienen mejor rendimiento que los discos mecánicos. Existen distintos tipos de SSDs, tenemos SSDs con interfaz SATA, SAS o tarjetas PCIe que contienen SSD o memoria Flash para poder acelerar operaciones de I/O a nivel del servidor. Cabe destacar que este pequeño intro a los SSDs no es tantito la vista completa de como trabaja un SSD, recuerden investigar mas sobre el tema.

¿Que es vFlash?

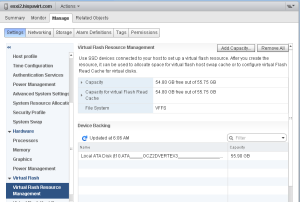

Lo se, bastantes términos e introducción pero debemos sentar las bases para poder platicar de manera mas profunda sobre la funcionalidad… vFlash es una solución 100% basada en el hipervisor, es decir, existe como parte del core del hipervisor (ESXi) por lo que no depende de ningún appliance virtual u otro enfoque, nos permite acelerar operaciones de lecturas a nivel de VMDK de VM a través de SSDs locales que hacen las veces de cache y sin necesidad que estos sean exactamente iguales en cuanto a modelo, tamaños y demás. El administrador de la infraestructura deberá configurar el pool de recursos de vFlash (que estará construyendo el sistema de archivos VFFS) a partir de discos de estado solido conectados directamente a los servidores ESXi, esto lo podemos notar en la siguiente imagen:

Aquí podemos notar que en mi laboratorio seleccione un SSD de 55GB (en realidad son 60GB) para ser formar parte de VFFS, una vez que dejamos listo el o los distintos discos de estado solido que conformaran nuestro pool de recursos solo es cuestión de repartir de manera individual este espacio disponible para cada VMDK de VM, es importante saber que nosotros tenemos la opción incluso de solo acelerar un disco de una VM que tenga mas discos o VMDKs esto nos da la posibilidad de tener un control mucho mas granular en la entrega de este cache basándonos en el perfil de I/O que presenta nuestras VMs. Una herramienta que nos puede ayudar en poder conocer que perfil de I/O manejan nuestras VMs es el ya confiable y ampliamente utilzado vscsiStats donde podemos conocer todo tipo de información como el tamaño de operaciones, latencia,entre otras, aquí les dejo algunos artículos de mi blog donde pueden leer mas sobre vscsiStats:

Aquí podemos notar que en mi laboratorio seleccione un SSD de 55GB (en realidad son 60GB) para ser formar parte de VFFS, una vez que dejamos listo el o los distintos discos de estado solido que conformaran nuestro pool de recursos solo es cuestión de repartir de manera individual este espacio disponible para cada VMDK de VM, es importante saber que nosotros tenemos la opción incluso de solo acelerar un disco de una VM que tenga mas discos o VMDKs esto nos da la posibilidad de tener un control mucho mas granular en la entrega de este cache basándonos en el perfil de I/O que presenta nuestras VMs. Una herramienta que nos puede ayudar en poder conocer que perfil de I/O manejan nuestras VMs es el ya confiable y ampliamente utilzado vscsiStats donde podemos conocer todo tipo de información como el tamaño de operaciones, latencia,entre otras, aquí les dejo algunos artículos de mi blog donde pueden leer mas sobre vscsiStats:

VCAP – Sección 3 – utilizar herramientas avanzadas para el monitoreo de performance

VCAP – Sección 6 – Troubleshooting de almacenamiento

Es importante conocer el patrón de I/O que presentan nuestras VMs debido a que en la configuración de vFlash a nivel de VDMK definiremos tamaño del cache y bloque del mismo (lo mejor es que sea el mismo que el utilizado por la aplicación/servicio):

En cuanto a requerimientos para poder habilitar este cache a nivel del VMDK de nuestras VMs solo tenemos los siguientes:

La configuración de esta funcionalidad es únicamente a través del vSphere Web client, al igual que todas las funcionalidades nuevas que se han ido agregando a vSphere solo están y estarán disponibles desde el cliente basado en web. Una vez configurado el cache este es transparente para la VM pero tiene ciertas consideraciones de diseño que estaremos revisando más adelante.

Arquitectura

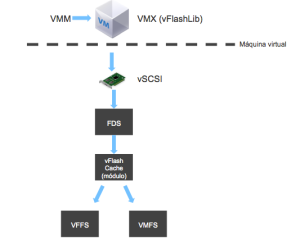

vFlash introdujo algunos nuevos componentes a ESXi y de igual manera al stack de I/O de la VM (solo en caso del VMDK que esta habilitado con vFlash) se tienen dos componentes nuevos:

El flujo de información se vería mas o menos de esta manera:

Cada vez que se enciende una VM se crea su cache, es decir, este no es persistente a reincios y demás, vFlashlib lo crea una vez que el proceso de VM (VMM) comienza, el pool de recursos que a su vez construye el sistema de archivos VFFS es un sistema de archivos que existe a todo momento e incluso tiene un punto de montaje en /vmfs/devices/vflash/.

Cada vez que se enciende una VM se crea su cache, es decir, este no es persistente a reincios y demás, vFlashlib lo crea una vez que el proceso de VM (VMM) comienza, el pool de recursos que a su vez construye el sistema de archivos VFFS es un sistema de archivos que existe a todo momento e incluso tiene un punto de montaje en /vmfs/devices/vflash/.

Interoperabilidad

En el momento que consideramos integrar vFlash en nuestros diseños de infraestructura la primera pregunta sería ¿Como afecta y/o como trabaja con otras funcionalidades como HA, vMotion,DRS, etc?, vamos a revisar cada una de las funcionalidades mas relevantes de vSphere:

Consideraciones extra

Acá podemos encontrar algunas consideraciones y limites de vFlash en esta versión:

Casos de uso

Podemos ver que esta versión inicial de vFlash puede cubrir ciertos requerimientos de aplicaciones, en general aplicaciones con muchas lecturas. vFlash nos permite agregar mayor cantidad de aplicaciones críticas, pero un caso de uso que a mi me llama mucho la atención es VDI, y ¿Porque VDI? pues es simple, podemos descargar bastantes operaciones de I/O (lecturas) del almacenamiento y que estas sean servidas a partir del mismo SSD local (mejorando drásticamente el rendimiento de dichas operaciones) esto se vería bastante claro en la carga que recibe la replica si estuviéramos hablando de horizon view. En este punto Horizon View 5.2 no esta soportado para vFlash, aunque técnicamente no tendría problema para funcionar esto no será soportado oficialmente por servicios de soporte VMware (Global Support Services, GSS).

Conclusión

vFlash nos permite reducir la carga a nivel de nuestro almacenamiento centralizado (sería bueno incluso hablar de vSAN :D) a través de disco “barato” porque al final del día es mas costoso adquirir mayor cantidad de IOPS a nivel de una SAN/NAS que entregándolos a partir de disco SSD local. Existen distintas soluciones allá afuera que ofrecen este tipo de funcionalidades con otras ventajas, como por ejemplo, PernixData FVP y Proximal Data AutoCache

Estén atentos a mis siguientes artículos, donde estaré cubriendo el monitoreo de vFlash, a través de linea de comando y de los distintos indicadores de rendimiento que fueron agregados a nivel de vCenter.

De igual manera les recomiendo leer los links que estaré actualizando en este articulo sobre vFlash:

FAQs por Duncan Epping (Yellow Bricks) Frequently asked questions about vSphere Flash Read Cache